robots是网站跟爬虫间的协议,用大略直接的***格式文本办法见告对应的爬虫被许可的权限,也便是说robots.***是搜索引擎中访问网站的时候要查看的第一个文件。当一个搜索蜘蛛访问一个站点时,它会首先检讨该站点根目录下是否存在robots.***,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

robots在SEO中的浸染

在进行网站优化的时候,常常会利用robots文件把一些内容不想让蜘蛛抓取,什么是robots.***文件?

搜索引擎通过一种爬虫spider程序(又称搜索蜘蛛、robot、搜索机器人等),自动搜集互联网上的网页并获取干系信息。

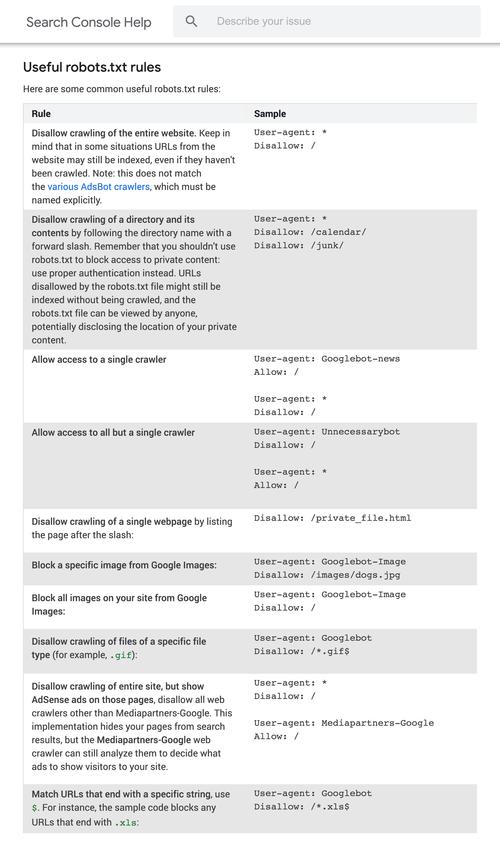

鉴于网络安全与隐私的考虑,搜索引擎遵照robots.***协议。通过根目录中创建的纯文本文件robots.***,网站可以声明不想被robots访问的部分。每个网站都可以自主掌握网站是否乐意被搜索引擎收录,或者指定搜索引擎只收录指定的内容。当一个搜索引擎的爬虫访问一个站点时,它会首先检讨该站点根目录下是否存在robots.***,如果该文件不存在,那么爬虫就沿着链接抓取,如果存在,爬虫就会按照该文件中的内容来确定访问的范围。