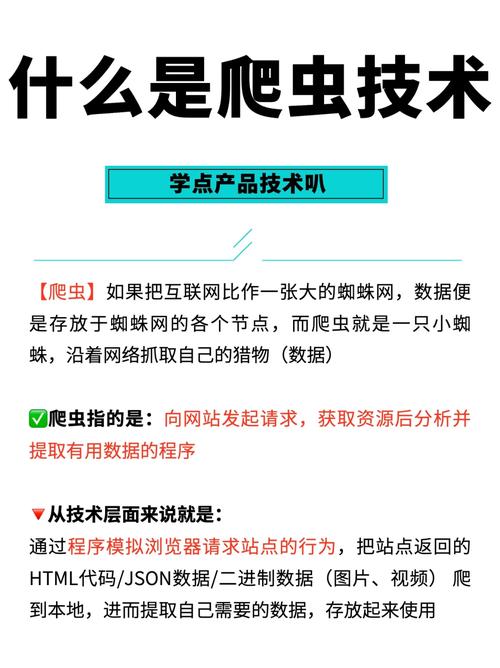

在互联网高速发展的今天,网站已经成为信息传播的重要平台。随着爬虫技术的日益成熟,网站内容被大量复制、盗用现象日益严重,给网站运营者带来了巨大的困扰。为了保护网站内容,防爬虫设计成为了一个重要的课题。本文将从防爬虫技术的原理、方法以及实际应用等方面进行探讨。

一、防爬虫技术原理

防爬虫技术主要是通过识别爬虫程序的特征,对爬虫程序进行拦截和限制,从而保护网站内容。其原理主要包括以下几个方面:

1. 用户代理识别:通过检测请求的User-Agent字符串,判断请求是否来自爬虫程序。常见的爬虫程序如百度蜘蛛、谷歌爬虫等,都有自己的User-Agent标识。

2. 请求频率控制:通过对同一IP地址在短时间内发送请求的数量进行限制,防止爬虫程序进行大规模爬取。

3. 请求来源限制:对请求的来源IP地址进行限制,防止爬虫程序通过代理服务器进行攻击。

4. 请求内容验证:通过验证请求内容是否符合网站规定的格式,防止爬虫程序进行恶意请求。

二、防爬虫方法

1. 服务器端防爬虫

(1)设置robots.***文件:通过编写robots.***文件,告诉爬虫程序哪些页面可以爬取,哪些页面不可以爬取。

(2)自定义403错误页面:当爬虫程序访问受限页面时,返回自定义的403错误页面,提示爬虫程序访问失败。

(3)使用验证码:在登录、注册等关键页面设置验证码,防止爬虫程序自动填写表单。

(4)使用服务器端验证码:通过服务器端生成验证码,确保验证码的唯一性和有效性。

2. 客户端防爬虫

(1)设置HTTP头部:通过设置HTTP头部字段,如X-Robots-Tag,告诉爬虫程序是否可以爬取页面。

(2)使用JavaScript技术:通过JavaScript技术生成动态内容,使得爬虫程序无法获取到完整的数据。

(3)使用图片验证码:在关键页面设置图片验证码,增加爬虫程序的破解难度。

三、防爬虫实际应用

1. 搜索引擎优化(SEO):通过防爬虫技术,保护网站原创内容,提高搜索引擎排名。

2. 数据保护:防止爬虫程序抓取网站敏感数据,如用户隐私、交易数据等。

3. 网站运营:通过限制爬虫程序访问,减轻服务器压力,提高网站稳定性。

4. 内容版权保护:防止网站内容被恶意盗用,维护网站合法权益。

网站防爬虫设计是保护网站内容的重要手段。在实际应用中,应根据网站特点选择合适的防爬虫方法,结合服务器端和客户端技术,实现有效的内容保护。随着爬虫技术的发展,防爬虫技术也需要不断创新,以适应新的挑战。

引用权威资料:

《网络安全法》第十二条:任何个人和组织不得利用网络从事危害国家安全、荣誉和利益,扰乱社会经济秩序,损害公民、法人和其他组织合法权益等活动。

《互联网信息服务管理办法》第十四条:互联网信息服务提供者应当采取措施,防止他人利用其服务从事危害国家安全、荣誉和利益,扰乱社会经济秩序,损害公民、法人和其他组织合法权益等活动。

随着互联网的不断发展,网站防爬虫设计已成为网站运营者必须关注的问题。通过了解防爬虫技术原理、方法和实际应用,网站运营者可以更好地保护网站内容,维护自身合法权益。